La curiosità mi porta spesso a fare considerazioni che forse uno specialista potrebbe trovare azzardate o lunari. Ma sono abbastanza convinto che lo storico che è in me abbia individuato in questa che stiamo vivendo la terza rivoluzione informatica. (Nota già qui: sono graditi commenti esperti, anche e soprattutto a negare le mie tesi).

Considerando Turing e Bletchley Park come la preistoria, e gli hackers del MIT degli ‘50 come la necessaria premessa, la prima rivoluzione è senza dubbio quella del personal computer. Da lì, l’informatica inizia la sua corsa verso la massa (e sviluppa un nuovo ecosistema imprenditoriale, ‘member Olivetti, Microsoft, Apple, per dirne tre) pesantemente influenzata dalla cultura freak hippy che permeava quella California (sì, nella storia più capitalistica dell’umanità c’è un germe anarchico, all’interno, e forse questa cosa non è tanto contraddittoria).

Ad ogni modo, la seconda rivoluzione è certamente l’esplosione del web. Anche in questo caso, nuovo ecosistema, rimediazione di tecnologie già esistenti, esplosione di un nuovo ecosistema imprenditoriale (in questo caso ancor più grande del precedente, e con una partenza interrotta e ripresa, come la crisi delle dot com è lì a ricordare).

Di certo la diffusione dei dispositivi portatili, che ci ha consentito di avere internet sempre con noi, è stata la seconda rivoluzione e mezza, una rivoluzione anche in questo caso propedeutica alla creazione di un nuovo paradigma, visto che è solo con questi dispositivi che la pervasività dell’informatica, e di internet, trova pieno compimento.

Un telefono, o più, in ogni tasca. Un telefono che raccoglie dati (certo, lo fanno anche i computer, ma non ci portiamo il computer sulla tazza, o almeno, io lo facevo prima degli smartphone, ma io sono io).

Perché la terza rivoluzione informatica parte da qui, parte dai dati (e ancora non sappiamo dove arriverà).

L’intuizione statale (semplice, naturalmente) post 09/11 muove la politica e l’economia americana e, quando i fondi di venture capital vengono massicciamente utilizzati per quelli che oggi chiamiamo i “gitanti del web” ma dovremmo chiamare “i giganti dei dati”, il futuro è segnato: si ricomincia a correre, dopo lo scoppio della bolla, e chi correrà di più sarà chi riuscirà a farsi dare dagli utenti la quantità più grossa di dati personali.

Non è mia pretesa fare un resoconto storico e tecnico dettagliato, ma riportarvi giustamente qualche ricordo: la fine degli anni ‘90, per me che mi affacciavo alle meraviglie delle nuove tecnologie, è stato un periodo magnifico, tutto sembrava possibile. Ad un certo punto, dopo le magie del basic (la mia prima folgorazione figlia del Commodore 64) potevamo creare contenuti che tutti vedessero: ecco allora che si iniziava a parlare di ftp, di mysql, di file e database. Si sperimentava e nascevano le professioni, anche nella provincia dell’impero chiamata Italia.

Anche io l’ho fatto: dal fare il sito per gli amici, nel quale mettere le foto delle nostre vacanze, mi sono ritrovato a lavorare con cose che avevano a che fare, spesso pesantemente, con l’informatica. E io amo l’informatica.

Quando si è dentro un mondo, a volte si fatica a vedere come gli altri mondi stiano cambiando.

Qualche mese fa, infatti, stavo cercando una soluzione ad un problema che mi affliggeva, professionalmente si intenda. Facevo parte di due gruppi di lavoro che operavano su questioni complementari, con modalità diverse. Ogni gruppo era autonomo ed indipendente: in questo vedevo uno spreco di risorse. Per cercare di risolvere questo problema mi sono rimesso a studiare.

Devo ringraziare internet in generale, e Linkedin in questo caso particolare: oggi possiamo accedere a una quantità di risorse per la formazione professionale e l’apprendimento che non ha precedenti nella storia dell’umanità; anche di questo parlerò, perché credo sia uno dei punti di svolta cruciali dell’umanità, in questo inizio turbolento di nuovo millennio.

Ad ogni modo ricomincio a studiare le metodologie Agile per lo sviluppo software: ed effettivamente trovo in Scrum un modello che potrebbe rispondere alle mie esigenze. In parallelo, capisco come con Kanban, a dispetto della meravigliosa patina di work life balance che queste nuove tecniche portano, sia possibile continuare e massimizzare lo sfruttamento del lavoro: l’uso smodato della metodologia Kanban nell’industria dei videogame è lì a dimostrarlo).

Le metodologie Agile incorporano l’incertezza nel processo produttivo, sono flessibili, collaborative, consentono la diffusione di competenze orizzontali e verticali.

La cosa può funzionare, mi dico. Ma sono sempre stato uno studente onnivoro, e quando inizio a studiare qualcosa poi espando.

E infatti, insieme alle metodologie Agile, affronto corsi di Dev-Ops, fino ad arrivare al cloud computing. Inizialmente frastornato da quelle che mi appaiono essere buzz word, fatico a vedere il nesso. Da quando conosco l’informatica, sono sempre riuscito a capirne i legami tecnologici senza particolare fatica. Ma inizio ad intravedere in questo nuovo modo di fare software un certo ritmo: automazione dei test, automazione della messa in produzione del software, automazione nella gestione delle risorse lato server… serverless. Ad un certo punto mi imbatto nella definizione di serverless.

Una lezione cruciale: capisco che oggi è possibile sviluppare software in maniera completamente nuova. Ad ogni funzione un pezzo di codice (microservizio o servizio), nel linguaggio che si preferisce, tanto saranno le AI dei rispettivi cloud ad attribuire le risorse necessarie al funzionamento del servizio. E ogni servizio o micro-servizio, ogni funzione, diventa un canale per far passare dati: c’è chi lo chiama il regno delle API.

E il regno delle API è possibile solo se si inizia a pensare (in gergo e in fondo, progettare) software a partire dalle user story, dalle storie dell’utente, una tecnica di progettazione intimamente collegata alle metodologie Agile.

Tutto trova ritmo, dai bisogni dell’uomo al calcolo della macchina in cloud per erogare il servizio che risponde a quel bisogno. Un ritmo nuovo tra uomo e macchina, completamente opaco per l’utente.

Ricordo infatti una vecchia battuta: it’s not cloud, it’s just someone else computer. E questo era vero finché nel cloud portavamo la stessa struttura server-client che potevamo farci in casa, senza l’uso dell’intelligenza artificiale.

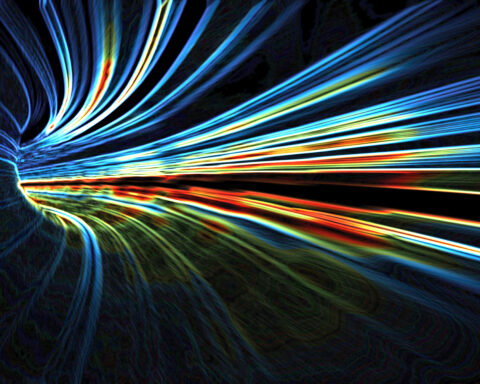

Oggi, invece, con la progettazione a micro-servizi, il cloud diventa un’altra cosa: diventa la realizzazione della matrix e del cyberspazio di Gibson:

“The matrix has its roots in primitive arcade games,” said the voice-over, “in early graphics programs and military experimentatlon with cranial lacks.” On the Sony, a two-dimensional space war faded behind a torest of mathematically generated ferns, demonstrating the spatial possibilities of logarithmic spirals: cold blue military footage burned through, lab animals wired into test systems, helmets feeding into fire control circuits of tanks and war planes. “Cyberspace. A consensual hallucination experienced daily by billions of legitimate operators, in every nation, by children being taught mathematic concepts . . . A graphic representation of data abstracted from the banks of every computer in the human svstem. Unthinkable complexity. Lines of light ranged in the nonspace of the mind, clusters and constellations of data.

William Gibson – Neuromancer

Una rappresentazione grafica di astrazioni di dati dai banchi di ogni computer. Una impensabile complessità. Linee di luce che attraversano il non spazio della mente, i cluster e le costellazioni di dati. Sono le AI che, in modo dinamico, gestiscono i dati che oggi facciamo passare nei cloud.

Ha iniziato Netflix nel 2011, a sviluppare a microservizi: Netflix, infatti, è stata la prima grande a fare uso massiccio di intelligenza artificiale, sia per le proprie applicazioni, sia per l’analisi dei gusti degli utenti e la micro-profilazione. Capito che questo tipo di sviluppo funzionava, si è diffuso a macchia d’olio: Spotify, prima, poi Amazon (che di Netflix è partner un pochino troppo stretto) e via via tutti gli altri.

Non sono le tecnologie ad essere al centro di questo nuovo ecosistema, non sono loro le protagoniste della terza rivoluzione digitale: sono i dati.

Affinché le AI possano utilizzarli al meglio, per aiutarci a rispondere alle domande più complesse, esse stesse ci hanno indicato la via: già oggi sviluppiamo per far lavorare meglio le macchine, per alimentarle con più dati, più veloci, con più volume, più vari. Sono le AI a regolare il ritmo della produzione del software, oggi, ai livelli più alti: un ribaltamento ironico dal quale capiamo che, per un certo verso, siamo già noi a servire le macchine e non il contrario.

Il 5G e l’edge computing completano il quadro: un vero e proprio cyberspazio di dati, dove la posizione del dato stesso segue la necessità dell’utente, lo accompagna, si rende disponibile: sembra letteratura, ma è la necessità, per esempio, della automobili a guida autonoma.

Approfondiremo certamente questa prima impressione di un mondo che cambia, di quella che considero essere la terza rivoluzione informatica: una rivoluzione che combina tecnologie (cloud e 5G, per esempio), tecniche (la continuous integration e le metodologie Agile) nuovi paradigmi e filosofie dell’interazione uomo macchina (come l’uso delle storie dell’utente, delle personas, degli scenari d’utilizzo): un mix critico, un cambiamento epocale che è già in corso.

Per chi non è in grado di intuire il cambiamento potrebbero essere dolori: innanzi tutto, riguardo ai dati, il primo che arriva e inizia a creare modelli ha un vantaggio competitivo non indifferente; in secondo luogo c’è cloud e cloud.

Finora infatti, nella definizione di cloud, mi son tenuto generico: intendo i cloud dei principali operatori, AWS, Google, quegli OTT che sono in grado di alimentare con AI raffinatissime l’erogazione delle risorse ai micro-servizi. Ma la strepitosa forza ed efficienza economica dei cloud di primo piano ha un costo importante: la libbra di carne che concediamo sono tutti i nostri dati, o quasi tutti.

Esiste la possibilità di creare private cloud, che svolgano, more or less, le stesse attività descritte sopra, per creare ecosistemi privati di dati efficienti, in cloud, per il 5G e in edge computing. La possibilità di difendersi dai giganti esiste, ma le competenze latitano.

Ed è proprio a questo punto che concludo quella che ritengo essere una lunga e complessa introduzione di capitoli che andranno a scriversi: la grande spaccatura che viviamo al giorno d’oggi, in tantissimi spazi dell’agire umano, è un problema di competenze, un Mar Rosso che divide chi guarda avanti e chi no, chi ha la possibilità di farlo e chi no, tra chi ne ha volontà, e chi no.

Nel guardare avanti, però, i rischi di spaccare pezzi di società esistono, anche di lasciare indietro un pezzo di società che si pensa sulla frontiera della tecnologia, ma che spesso non lo è.

Da qui, di nuovo, consideriamoci tutti eterni studenti e ricominciano da dove avevamo lasciato: ricominciamo studiando, anche ogni giorno, anche nel nostro lavoro quotidiano, quale esso sia. L’innovazione continua, aiutata dalle AI, sta cambiando, letteralmente, tutto.

A margine: per me, da sempre, il cambiamento è, di per sé, innocente. Saremo noi, come esseri umani e umanità, a indirizzarlo. La sfida è grande, le responsabilità, pure. Ma, proprio di questi tempi, voglio guardare a Bill, con il rispetto che il giovane me non gli tributava, ingiustamente. Grazie per le parole in difesa dell’ottimismo, servono.